BESS(Back-End Study Space)

Recurrent Neural Network(RNN) 본문

2020/12/06 - [데이터 분석 입문/딥러닝] - Convolutional Neural Network(CNN)

Convolutional Neural Network(CNN)

2020/12/05 - [데이터 분석 입문/딥러닝] - Mini-Batch, Back Propagation, Overfitting Mini-Batch, Back Propagation, Overfitting 2020/12/05 - [데이터 분석 입문/딥러닝] - Perceptron, Deep Learning, Gradi..

leeezxxswd.tistory.com

#1. Recurrent Neural Network(RNN)

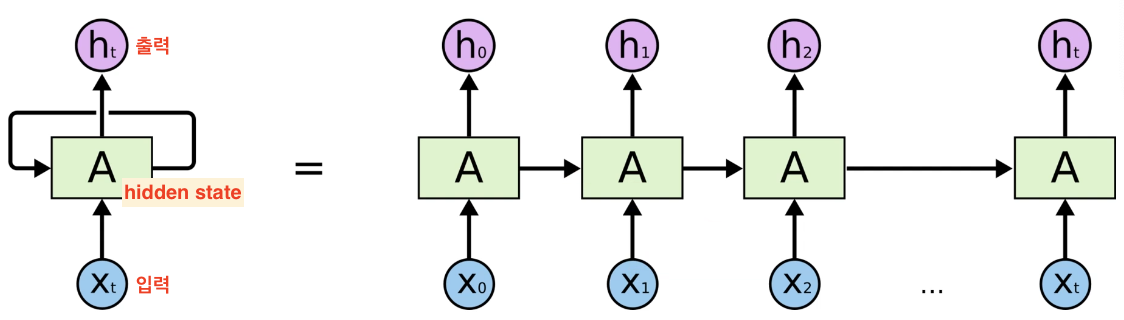

이전까지 들어온 입력이 저장된 공간 -state(아래 그림에서 A)가 존재함

새로운 입력과 함께, 이 state 값이 입력으로 같이 들어감

#2. RNN의 종류

#3. (Vanilla) RNN의 문제점

- sequence가 길어지면 성능이 떨어진다

- sequence가 길어지면 학습도 잘 안된다

- A 공간이 하나이다 보니 오래전 입력에 대해서는 기억을 잘 못한다. (Long Term Dependency)

- 예) Language model(검색어 자동완성 같은 기능) → 다음 단어를 예측하는 model

홍길동은 어제는 친구와 소풍을 다녀왔고 글피는 엄마를 따라 시장에 가서 반찬거리를 사오고

그 글피는 여자친구와 함께 비가 옴에도 불구하고 놀이동산에서 재미있게 놀고 왔기 때문에

오늘은 ________(자동완성 되어야 하는 부분)________

▶오늘은 무엇을 하는지의 주체는 '홍길동'인데 홍길동이 맨 처음에 나오고 나서 다음에 너무 많은 이야기가 나옴으로 인하여

누구에 대한 이야기를 자동완성으로 채워야 하는지 잘 몰라서 대답을 제대로 못하는 경우가 발생한다.

#4. LSTM과 GRU

RNN의 문제점을 해결하기 위해 만들어진 Network들로, Long Term Dependency를 해결하고 학습도 잘되게 도와준다.

- LSTM : Long Short Term Memory

- GRU : Gated Recurrent Unit

'데이터 분석 입문 > 딥러닝' 카테고리의 다른 글

| TensorFlow와 PyTorch (0) | 2020.12.07 |

|---|---|

| Generative Adversarial Network (0) | 2020.12.07 |

| Convolutional Neural Network(CNN) (0) | 2020.12.06 |

| Mini-Batch, Back Propagation, Overfitting (0) | 2020.12.05 |

| Perceptron, Deep Learning, Gradient Descent (0) | 2020.12.05 |